每个企业都在竞相实施人工智能。一些企业正在部署自主智能体(Agentic AI),这些智能体在业务系统中进行规划、推理和行动,调度、生成内容、处理工单,甚至执行交易。

然而,随着这些智能体工作流程的上线,裂缝出现了:智能体做出了一个有缺陷的决定,无休止地循环或触发了一个意想不到的动作。根本原因不是模型智能;缺少护栏、糟糕的背景或薄弱的验证。

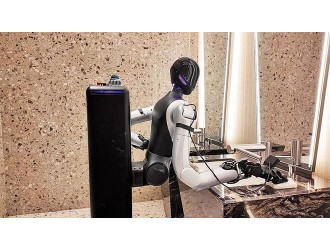

自主智能体系统的行为不像传统软件。它们是动态的、适应性强的,本质上是不可预测的。测试它们需要一个新的学科,一个融合了工程、治理和持续的人类监督的学科。以下策略采用这种混合方法进行智能体人工智能开发和质量保证,以帮助团队提高智能体和其他应用程序的整体质量。

一、将智能体置于当下值得信赖环境中

对于智能体工作流来说,成功并不在于庞大的训练数据集,而在于智能体用于推理和行动的信息的质量。当智能体依赖于不准确的检索、过时的数据或不完整的上下文时,它们会快速而确定地失败。

自主智能体根据所看到的采取行动。上下文漂移,来自过时的API、未经验证的文档或不一致的知识图,会破坏可靠性。企业应将上下文视为实时的基础设施:受管理、版本控制和持续验证。合成或缓存的数据有助于提高响应速度,但经过验证的实时信息必须始终是事实的来源。投资于上下文完整性,而不仅仅是数据量,可以确保智能体做出基于现实的决策。

二、微调域精度和控制

即使在使用基础模型时,企业也不能仅仅依赖通用推理。微调或快速调节可确保智能体正确解释业务规则、语气和合规性边界。

智能体行为必须反映组织的优先事项——准确性、安全性、品牌声音和风险承受能力。通过特定领域的微调、检索配置或受限的规划逻辑进行定制,有助于防止风险自主性并保持控制。

三、让人类持续在线

人的反馈不是补丁,它是控制系统的一部分。持续的监督使企业能够在造成伤害之前发现偏差、偏见或过度行为。结构化评估将自动预测与人类判断相结合,确保智能体决策保持道德、相关并与意图保持一致。

智能体很有说服力,但并不总是正确的。结合审查检查点、升级协议和反馈循环,使他们能够承担责任,而不会扼杀适应性。多样化的人工评估人员有助于揭示自动化测试遗漏的边缘案例和文化细微差别。

四、稳健安全的红队

智能体系统需要主动的压力测试。红队暴露了智能体在失败、操纵或冲突目标下的行为,从即时注入尝试到数据中毒或逻辑陷阱。

受控对抗测试在部署前识别漏洞。有效的红队合作将技术攻击模拟与道德和操作滥用场景相结合,确保自主智能体在生产环境中保持安全、一致和弹性。

五、现场企业条件下的测试和监控

任何虚拟环境都很难复制现实世界的复杂性。一旦智能体与实时数据、用户和工作流交互,意想不到的边缘情况就会出现。持续监控是企业如何在不减缓创新的情况下保持控制。

现实世界的评估捕捉到了紧急行为、绩效变化、情境相关性或合规性一致性。具有遥测、审计和自动回滚触发器的仪器智能体。可靠性不是一次性的认证;这是一个持续的承诺。

未来承诺

在人工智能领域获胜的企业不仅在部署智能体,还在构建运营生态系统,让智能体负责任地行事,以事实为基础,安全地发展。以上概述的五种策略是有效的质量衡量标准,但必须持续监控和调整,以确保随着智能体的增长和条件的变化而保持可靠性。

智能体系统的质量保证不是一个复选框。这是信任的架构。将其视为战略学科的公司,在每个阶段整合人类判断、测试严谨性和治理,将定义企业中负责任的自主性。

客服热线:

客服热线: